Hände weg vom FNIRSI 1013D

Hände weg vom FNIRSI 1013D Hände weg vom FNIRSI 1013D

Hände weg vom FNIRSI 1013D... es ist in der Praxis eher nur in Ausahmefällen brauchbar.

Nachtrag nach 16 Monaten: Ich erfuhr von einer Open Source Firmware, die sich verhältnismäßig einfach aufspielen lässt. Ich kenne sie nicht. Stand heute mag sie noch kleine Schwächen haben, aber ich nehme doch an, dass sie kontininuierlich verbessert wird:

https://github.com/pecostm32/FNIRSI_1013D_Firmware

中文版本。FNIRSI-1013D_cn.html

English Version: FNIRSI-1013D_en.html

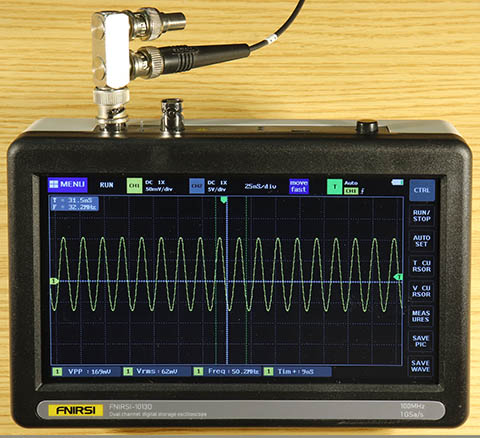

Ein Oszillskop mit 2 Kanälen, (angeblich) 100 MHz/1 GSa/s, portabel, mit anständiger Display-Größe, incl. 2 Tastköpfen für nicht viel mehr als 100 € kann eigentlich kein Fehlkauf sein, auch wenn nicht alles perfekt ist.

Dachte ich. Auch dass das mit den 100 MHz nicht stimmen kann, war vorher abzusehen. Mehr als 40 MHz kann nicht möglich sein, weil die ADCs mit max. 200 MHz arbeiten. Also eine glatte Lüge. Aber wann ist der Bereich bis 100 MHz bei ständig wechselnden Messaufgaben schon mal wichtig? Und das gilt auch für viele andere Spezialfunktionen. Also für den geringen Nutzen bei dem Preis kann ich gerne darauf verzichten. Wenn dann der Rest vernünftig funktioniert.

Tut er aber nicht. Das FNIRSI-1013D hat so große Macken, dass ich es für unbrauchbar halte. Ja, nicht eingeschränkt brauchbar, sondern ganz unbrauchbar.

Viele kleine Details, die fehlen, die nicht perfekt oder korrekt sind, will ich hier gar nicht erwähnen. Das würde nur von den beiden Eigenschaften ablenken, auf die ich mich hier konzentriere, und die jede für sich allein für Unbrauchbarkeit sorgen:

1. Das Kleinsignalverhalten und 2. die Unterabtastung.

Das Random-Sampling sollte auch erwähnt werden, denn deswegen ist die Darstellung schneller und veränderlicher Signale auch nicht möglich. Darüber hinaus scheint mir ein Software-Fehler, der gelegentlich für ein diskontinuerliche Darstellung auf der Zeitachse sorgt, ein wichtiges Thema zu sein.

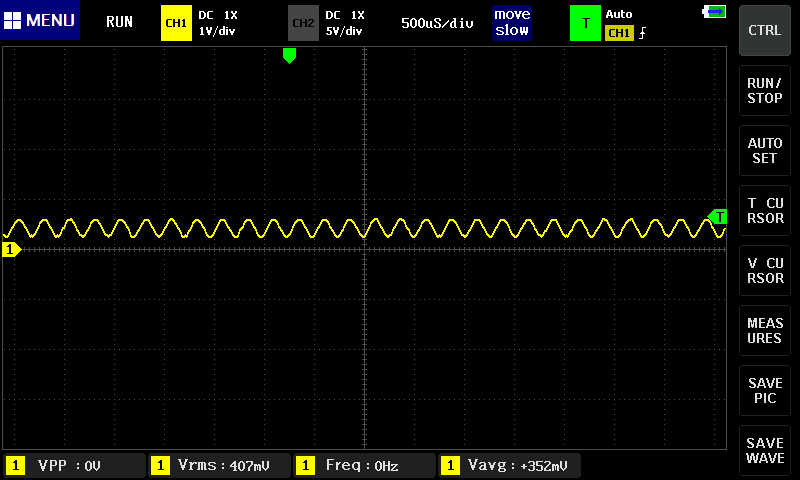

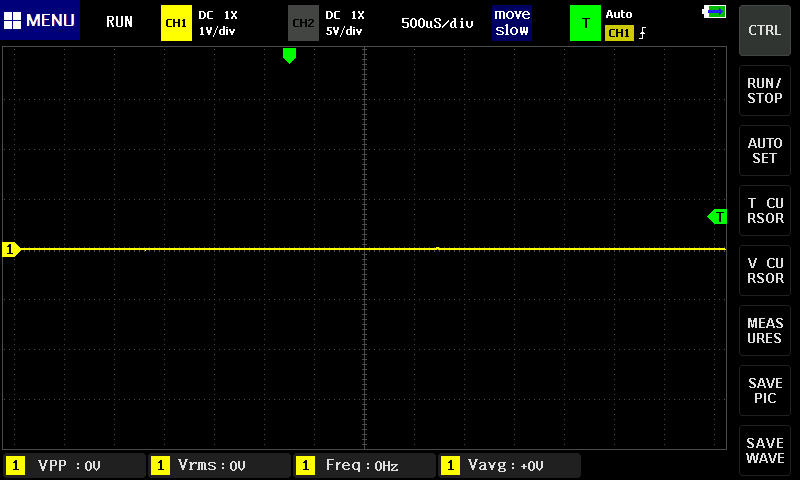

Es klingt unglaublich, aber DC-Spannungen zwischen +35 mV und -35 mV oder AC-Signale mit weniger als 35 mVss können nicht dargestellt werden. (DC heißt: Weitgehend konstant während einer Ablenk-Periode, also z. B. bei 1 kHz Signalfrequenz und einer Zeitbasis-Einstellung von 1 µs/div). Genauer: DC-Signale, die die 0-Linie des Kanals weder positiv noch negativ 0,7 Skalenteile über- bzw. unterschreiten, werden abgeschaltet. Eine glatte 0-Linie erscheint. Das sind 17% der gesamten Bildhöhe! Bei AC-Signalen sind es +/- 0,35 Skalenteile bzw. 8% Bildhöhe. Das gilt bei der höchsten Empfindlichkeit von 50 mV/div und ist bei anderen Einstellungen auch weniger, aber prinzipiell gleich. Ich halte das nicht für einen Fehler in der Firmware, sondern für Absicht, denn so dicke Fehler fallen sofort auf. Das ist völlig absurd, da kann man nicht mit arbeiten. Gar nicht.

Hier die Screenshots dazu:

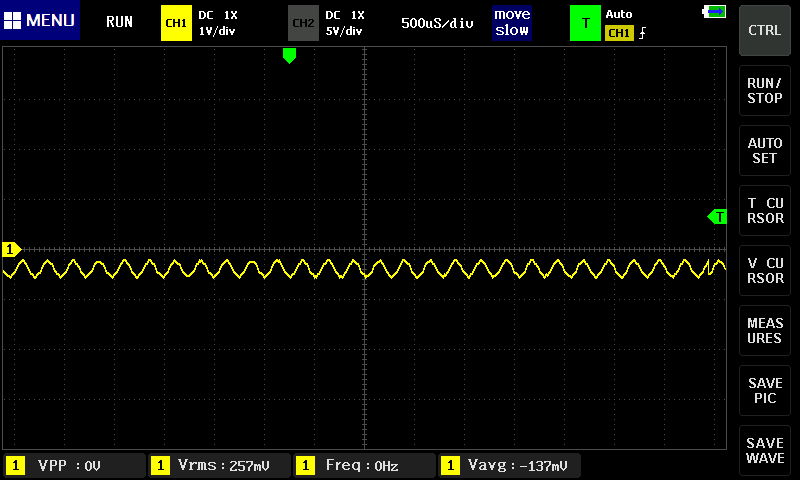

Dieses Signal mit einer Amplitude ca. 0,4 Skalenteilen und einem leichten DC-Offset von ca. 0,3 Skalenteilen ist an der Grenze des Darstellbaren. Mal überschreitet ein Pixel bzw. Messwert die Schwelle - dann ist es sichtbar (oben). Mal wird die Schwelle gerade nicht überschritten, dann wird die 0-Linie dargestellt (unten):

Wie gesagt, am Eingangssignal oder sonst irgendwie wurde zwischen diesen beiden Screenshots nichts verändert. Ich habe lediglich zweimal die Taste "SAVE PIC" gedrückt.

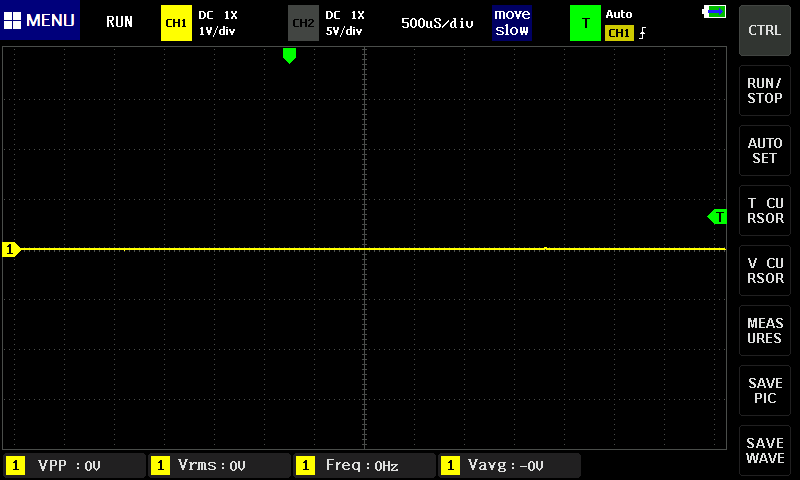

Im Negativen Bereich gilt das Gleiche: Mal wird das Signal nicht dargestellt...

... mal ist es sichtbar:

Am rechten Bildrand ist eine Unstetigkeit des Signals zu erkennen. Das ist kein Zufall, das ist das nächste Problem:

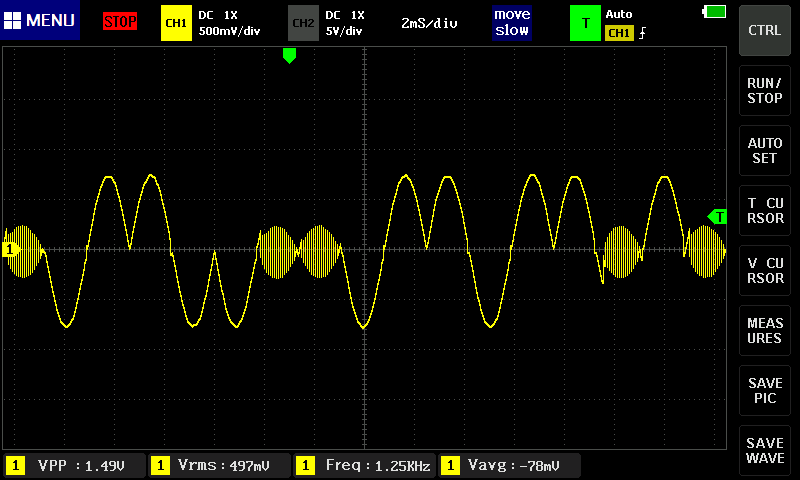

Das ist ein Effekt, den ich nicht provozieren kann, der aber manchmal auftritt und sich dann nicht einmal durch Ausschalten des Geräts beseitigen lässt. Signale sehen dann so aus:

Es passiert auch, dass der rechte Bereich von einem Signal aus einer früheren Messung stammt, also gar nicht zum aktuellen, linken Bereich passt. Wehe dem, der bei diesem Effekt eine Pulsfolge untersuchen will!

"Wenn ich nur 720 Abtastwerte aus der X-Achse darstellen kann, brauche ich das Signal in dieser Zeit auch nur 720-mal abzutasten" dachten sich wohl die Entwickler. Oder die Hardware hat nicht das ermöglicht, was erforderlich ist, um zu vermeiden, was dann passiert, und was bei jedem anderen Oszilloskop ganz selbstverständlich nicht passiert.

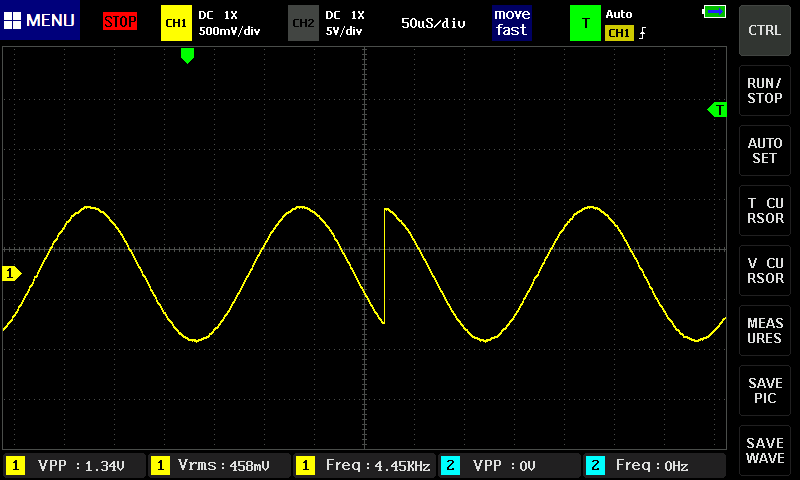

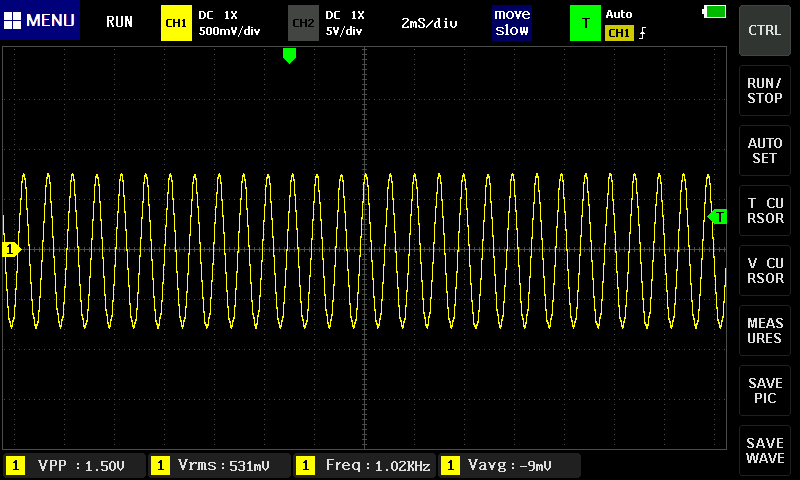

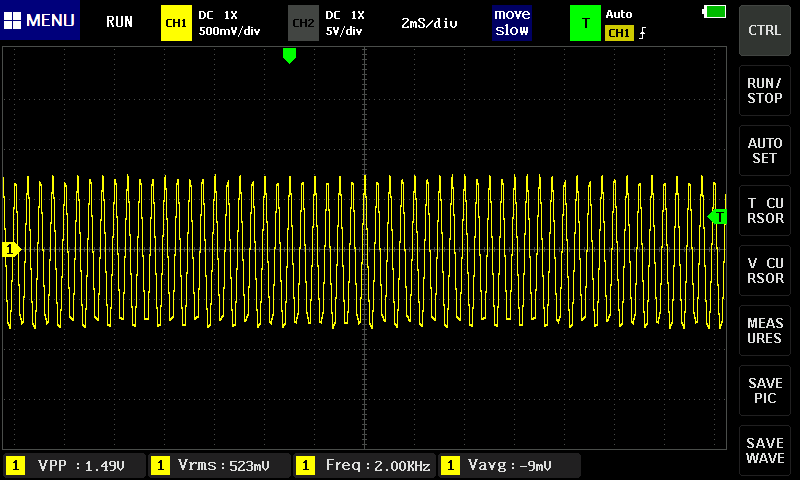

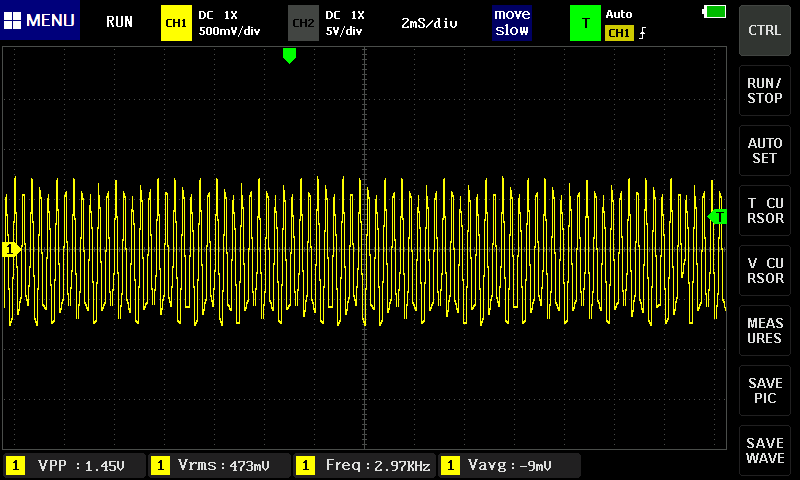

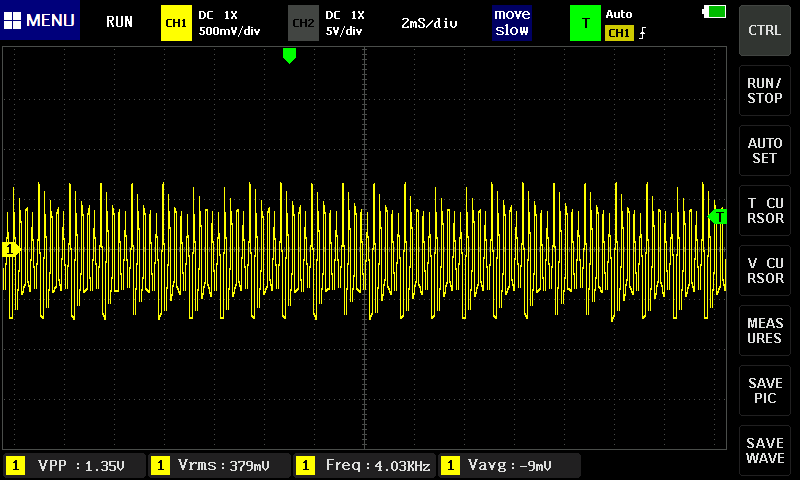

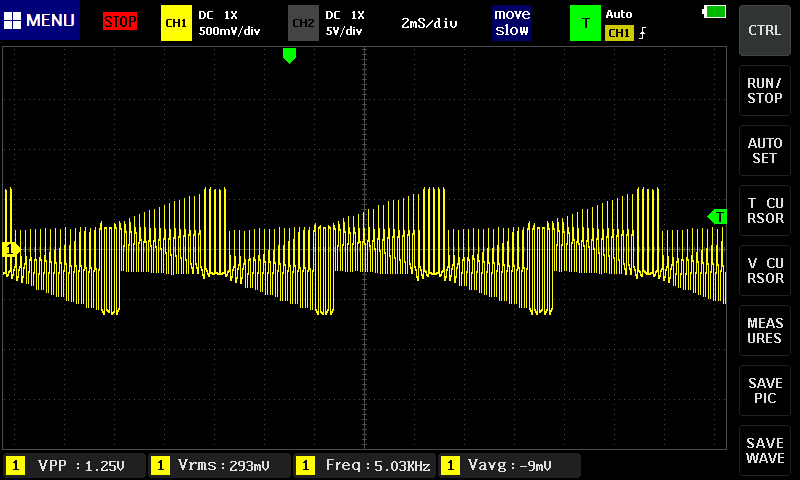

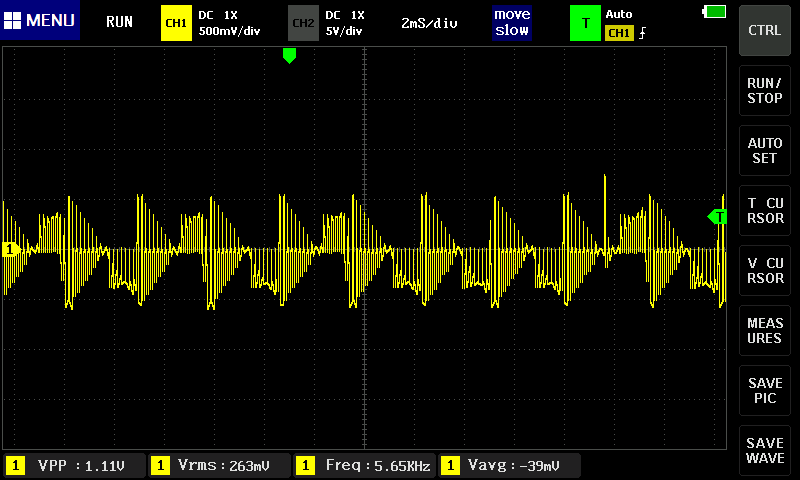

Beispiel: Zeitbasis 2 ms/div, Sinus-Signal mit 1 kHz bis > 10 kHz:

Zuerst 1 kHz, das sieht anständig aus:

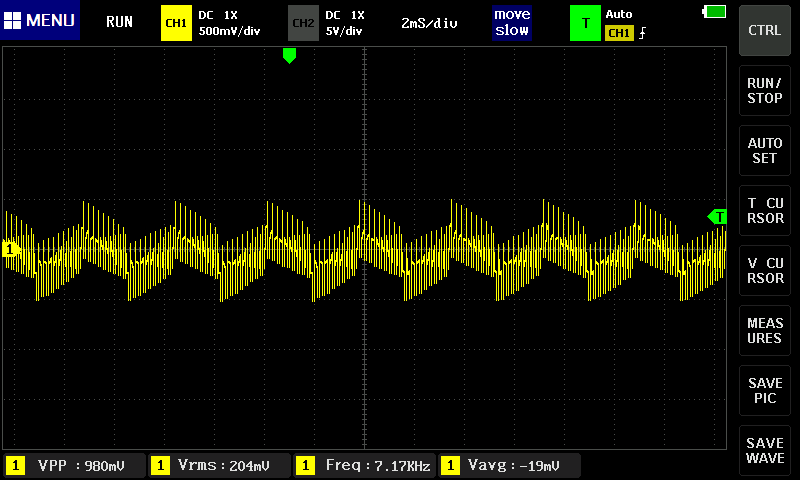

2 kHz sind schon unsauber:

Bei 3 kHz ist kein Sinus mehr zu erahnen. Typisch, nicht nur bei diesen Versuchen: Die Spitzen sind oben ausgeprägt, aber unten abgeflacht(?):

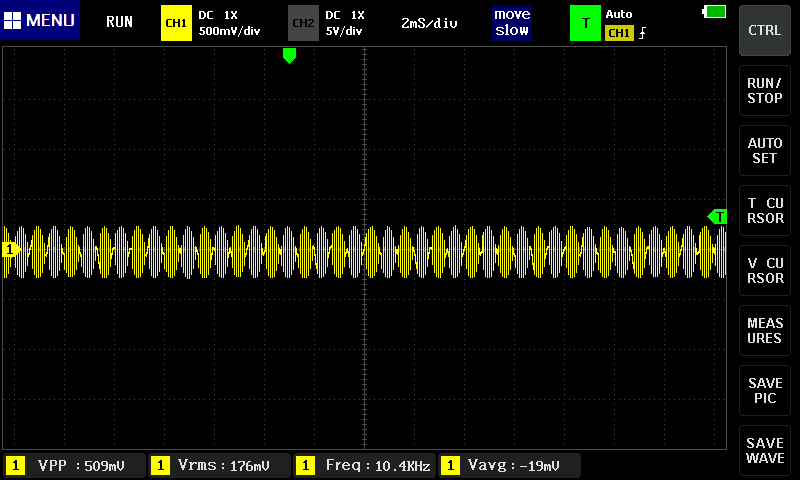

Bei 4 kHz wird es fast witzig, mit einfacher Unterabtastung ist das aber nicht mehr erklärbar:

Und 5 kHz sehen eher absurd aus, und spätestens hier wird klar, dass es sich hier nicht um eine normale Unterabtastung wie aus dem Lehrbuch, mit dem zu erwartenden Alias-Effekt handelt:

Spaßeshalber noch 6 kHz:

... und 7 kHz:

Jetzt noch 12 kHz:

... und weil der Effekt so putzig ist: Screenshot bei ca. 36 kHz, aber bei 13 kHz ist das Gleiche zu beobachten.

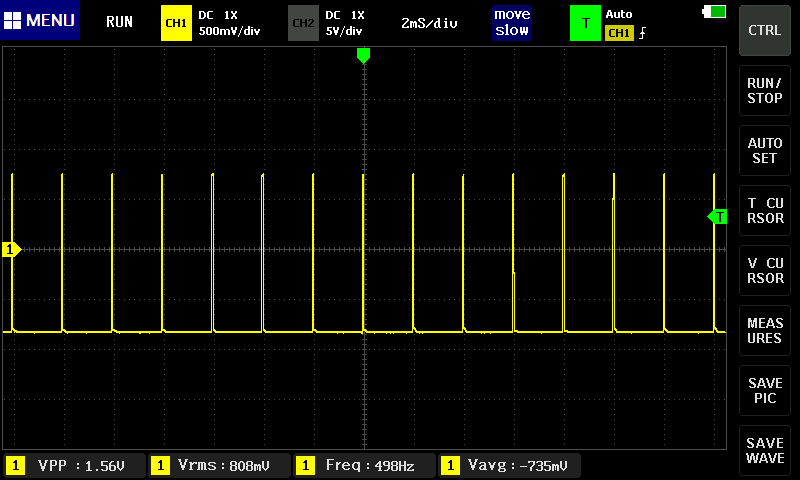

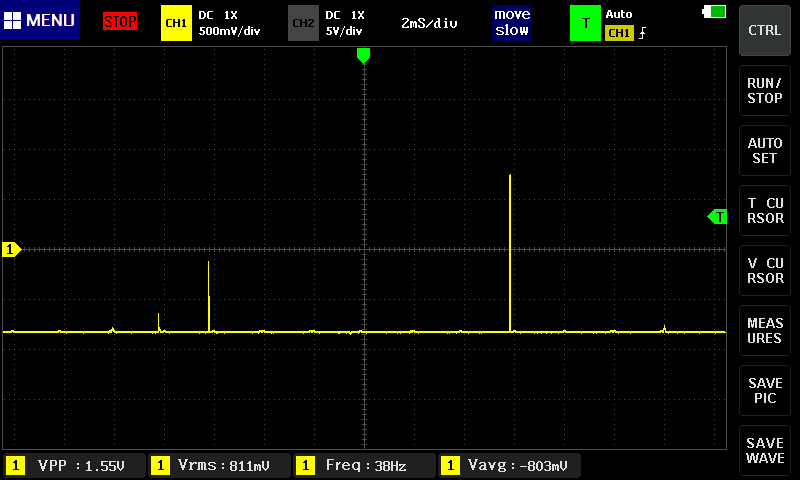

Ein anderer Effekt der "skrupellosen Unterabtastung" ist der, dass kurze Pulse vollständig verschluckt werden. Das Beispiel zeigt einmal einen 500 Hz-Puls mit 100 µs Impuls-Dauer, der bei 2 ms/div vollständig erfasst wird:

Aber schon bei nur 50 µs Impuls-Dauer gehen die meisten Impulse vollständig verloren, obwohl mindestens die Hälfte noch sichtbar sein müssten:

Bei höheren Frequenzen wird Random Sampling ("zufällige Abtastung") angewendet. Das heißt, dass mit der maximalen Abtastrate nicht ein einzelner "Schuss" aufgenommen wird, sondern dass das Signal mehrfach mit leicht versetzter Abtastphase aufgezeichnet wird, so dass auch Zwischenwerte ermittelt werden können. Dazu muss die Bandbreite im Analogteil natürlich hoch genug sein, und der ADC muss eine entsprechend geringe Sample-und-Hold-Zeit aufweisen. So kann man, zumindest prinzipiell, auch mit einen 200 MHz-ADC auf Sample-Frequenzen von 1 GHz und Bandbreiten von 100 MHz kommen.

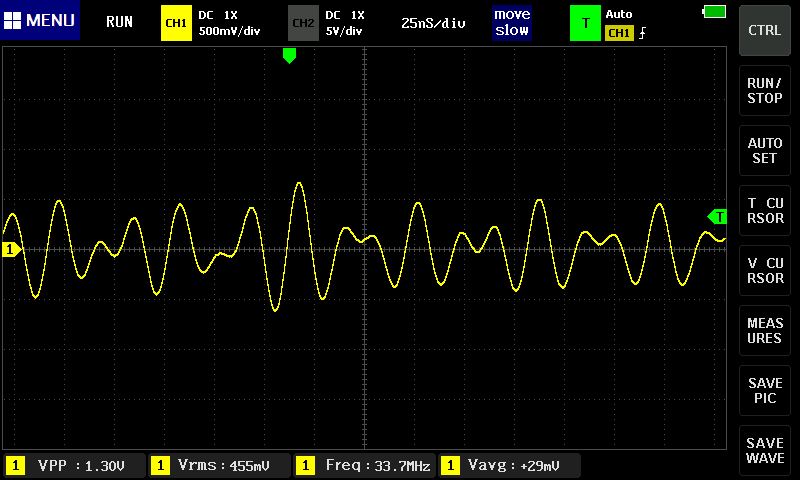

Der entscheidende Nachteil ist: Es müssen mehrere, identische Kurvenverläufe abgetastet werden. Bei einem einzelnen Impulszug funktioniert das nicht mehr. Im 1013D kann man, trotz der prinzipiell extrem kurzen Zeiten, zusehen, wie z. B. beim Umschalten der Signalfrequenz allmählich innerhalb ca. einer Sekunde die neue Signalform entsteht. Wie auf diesem Screenshot:

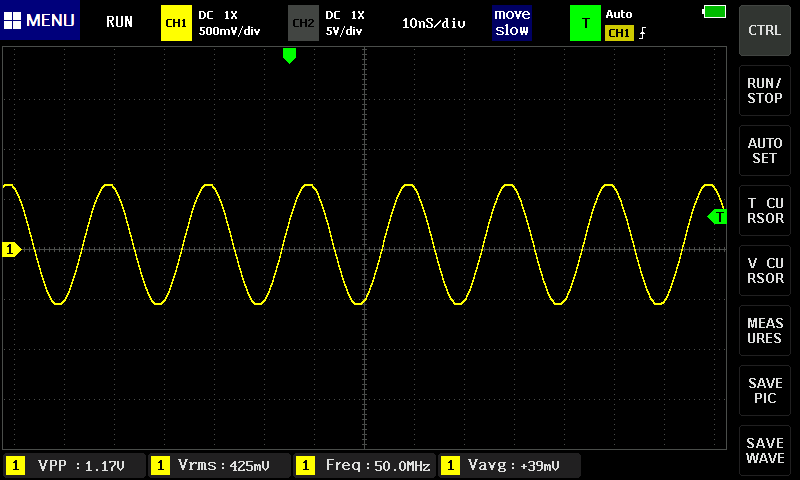

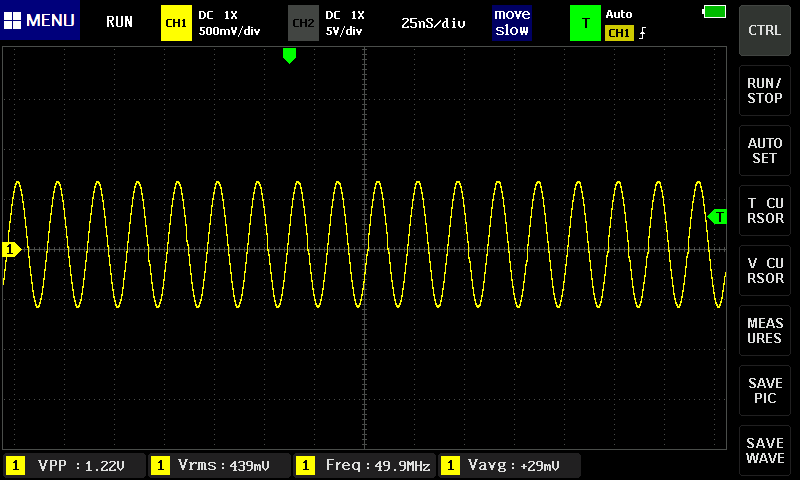

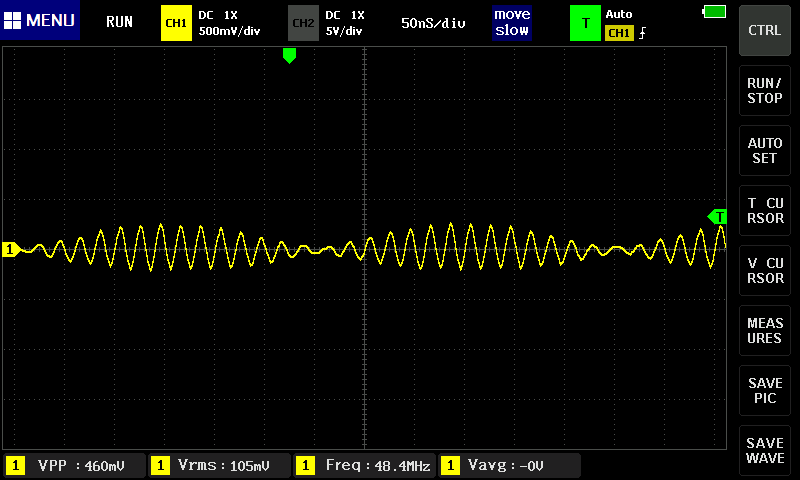

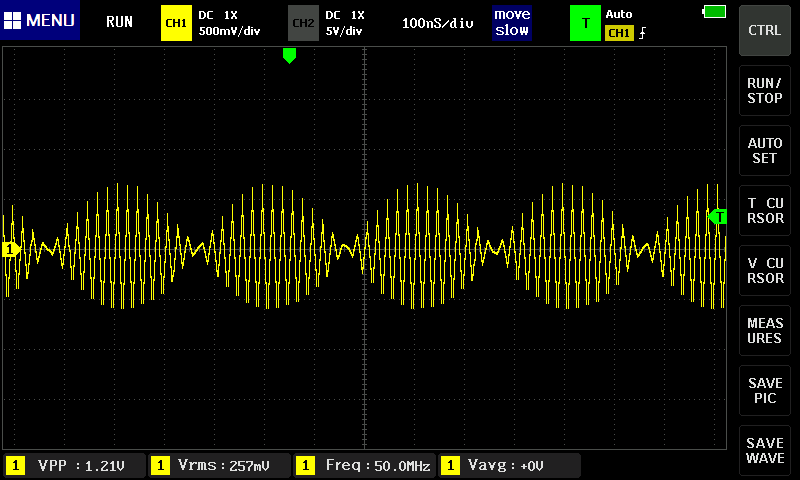

Dem entsprechend ist keine Aufzeichnung eines langsamen Sweeps von z. B. 0 bis 50 MHz, wie ihn mein Funktionsgenerator liefern kann, zur Bestimmung der Bandbreite möglich. Also lässt sich die Bandbreite bestenfalls mit einzelnen Sinussignalen bestimmen. Im Folgenden ein 50 MHz-Sinussignal bei unterschiedlicher Zeitbasis:

Bei 10 ns/div stimmt die Signalform und auch die Amplitude(!). Aber das ist wenig aussagekräftig, und nur für Messungen von kontinuierlichen Signalen interessant.

Bei 25 ns/div sieht es auch noch gut aus:

... aber bei 50 ns/div ist schon wieder Blödsinn zu sehen:

Bei Einstellungen der Zeitbasis von 100 ns/div und mehr wird kein Random Sampling mehr angewendet. Dadurch wird es, nicht verwunderlich, auch nicht besser:

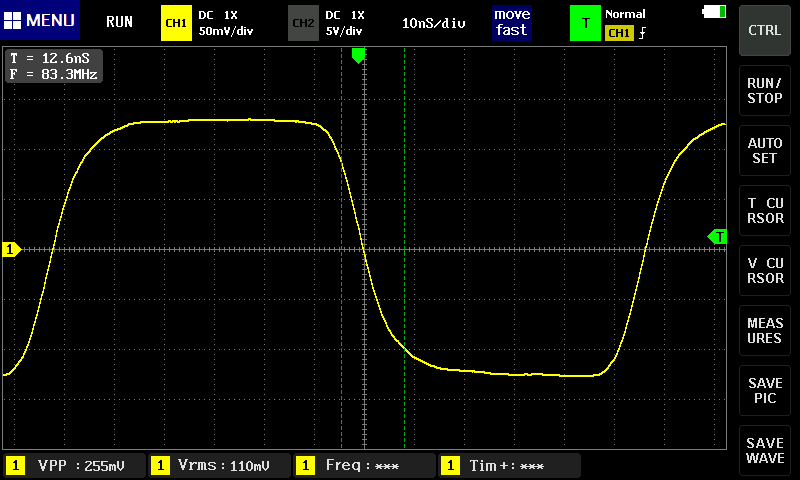

Ein anderer Versuch zum Thema Bandbreite: Die Quelle ist ein Rechtecksignal, ca. 8 Mhz, mit 7 ns Anstigszeit:

Die angezeigte Anstiegszeit von ca. 12,5 ns lässt nach der Berechnung t_Gen² + t_Oszi² = t_Disp², also t_Oszi = sqrt(t_Disp²-t_Gen²) auf eine Anstiegszeit des 1013D von ca. 10,5 ns schließen, was wiederum ca. 30 MHz Y-Bandbreite entspräche.

Es sei noch auf eine weitere lästige und unverständliche, aber im Zweifelsfall noch tolerierbare Eigenschaft des 1013D hingewiesen: Die Masse des USB-Anschluss liegt nicht auf dem Potential der Masse der BNC-Buchsen. Sobald z. B. ein eine Quelle mit Schutzerde und gleichzeitig das 1013D über USB mit einen PC verbunden ist, verursacht das eine erhebliche Y-Verschiebung der Messwerte zum Negativen hin. Man muss es nur wissen und die USB-Verbindung trennen, wenn die Messungen fortgesetzt werden.

Es könnte ein wirklich schönes und nützliches Gerät sein. Ein unschlagbares Preis-/Leistungsverhältnis, wunderbar für sparsame Anfänger als Einstiegsgerät und für den Profi als Zweit- oder Dritt-Gerät, wenn mal Portabilität gebraucht wird oder das Hauptgerät irgendwo eingebunden ist und/oder Leistung nicht ausschlaggebend ist.

Wenn bei der Entwicklung nicht irgendwann, etwas zu früh und mit bitteren Konsequenzen, "Feierabend" gemacht worden wäre, bevor es fertig war... Wie schade!

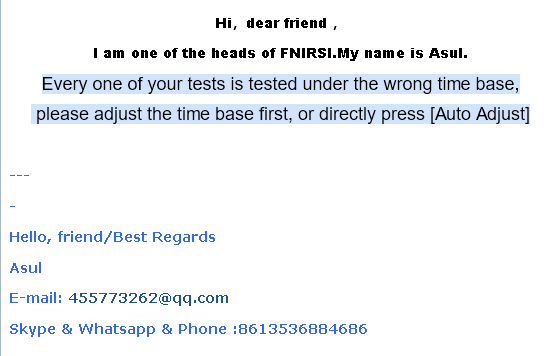

... nachdem ich u. A. auch ein Video geschickt hatte:

Ich bin also ein Vollidiot. Ok, verstanden.

| Letzte Aktualisierung: 16. Mai 2022 | Fragen? Anregungen? Schreiben Sie mir eine E-Mail! | Uwe Beis |